说明

我们总是吹嘘说高性能,那么高性能实现的方式有哪些呢?

常见的手段

Async 异步线程池执行

batch 批量执行

cache 引入缓存

index 数据库索引

chat

编程中总是说高性能,那么提升程序性能的方式有哪些?

提升程序性能是一个系统工程,需从硬件资源、算法设计、数据结构、代码实现、并行化、编译器优化及性能分析等多个维度综合优化。

以下基于资料分类详述核心优化策略:

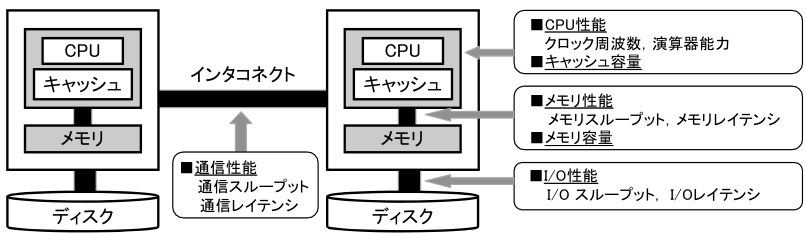

一、硬件资源优化

硬件是程序运行的物理基础,其性能直接影响程序效率。

- CPU优化

- 核心数与主频:多核处理器通过并行处理提升计算效率(并行任务需合理分配至不同核心)。

- 缓存利用:增大CPU缓存容量可减少内存访问延迟,例如通过优化数据局部性(如循环分块)提升缓存命中率。

- 核心数与主频:多核处理器通过并行处理提升计算效率(并行任务需合理分配至不同核心)。

- 内存优化

- 容量与频率:内存不足会导致频繁的磁盘交换(Swap),显著降低性能;高频内存可加速数据访问。

- 延迟优化:减少内存访问延迟(如通过预取技术提前加载数据)。

- 磁盘I/O优化

- SSD替代HDD:固态硬盘的随机读写速度远超机械硬盘,尤其适合I/O密集型程序(如数据库)。

- 批量读写:减少小文件频繁读写,合并为批量操作以减少系统调用开销。

- 网络优化

- 带宽与时延:高带宽网络提升数据传输速率,优化协议(如TCP窗口调整)可降低延迟。

二、算法与数据结构优化

算法复杂度是性能的底层决定因素,优化目标是降低时间/空间复杂度。

- 时间复杂度优化

- 高效算法选择:

- 用二分查找(O(log n))替代线性查找(O(n))。

- 动态规划避免重复计算(如斐波那契数列从O(2^n)优化至O(n))。 - 分治与剪枝:

- 快速排序(分治法)优于冒泡排序(O(n²))。

- 提前终止循环(如冒泡排序中未交换时提前退出)。

- 高效算法选择:

- 空间复杂度优化

- 精简数据结构:使用位图替代整数数组存储布尔值,节省内存。

- 数据复用:覆盖不再使用的数据,避免冗余存储。

- 数据结构选择

- 匹配操作需求:

| 操作 | 优选数据结构 | 时间复杂度 |

|—————-|—————-|————–|

| 高频查找 | 哈希表 | O(1) |

| 有序数据遍历 | 红黑树 | O(log n) |

| 大量重复数据 | 红黑树优于哈希表(避免哈希碰撞) |

- 避免退化:如哈希表在冲突严重时退化为链表,需调整哈希函数或扩容。

三、代码层优化技巧

微观优化能在不改变算法前提下提升局部效率。

- 减少系统调用

- 合并文件读写操作(如用

mmap替代多次read)。

- 合并文件读写操作(如用

- 循环优化

- 循环展开(Loop Unrolling):

// 优化前(1000次迭代) for (int i=0; i<1000; i++) process(array[i]); // 优化后(减少分支判断) for (int i=0; i<1000; i+=4) { process(array[i]); process(array[i+1]); ... // 展开4次 }

- 循环展开(Loop Unrolling):

适用场景:简单循环体且迭代次数固定,但需避免过度展开导致代码膨胀。

- 减少嵌套循环:将O(n²)优化为O(n log n)(如用哈希表替代双重循环查找)。

- 内存访问优化

- 内存对齐:

struct Unaligned { int a; char b; double c; }; // 可能因对齐浪费空间 struct Aligned { int a; char b; double c; } __attribute__((aligned(8))); // 显式对齐

对齐后减少缓存行(Cache Line)访问次数,提升缓存利用率。

- 数据局部性:顺序访问数组(避免随机跳转)提升缓存命中率。

四、并行与硬件加速

利用多核/GPU并行计算突破单线程性能瓶颈。

- 多核并行

- 任务分解:将大任务拆分为子任务,由多线程/进程并行处理(OpenMP、MPI)。

- 负载均衡:动态调度任务避免部分核心空闲(如工作窃取算法)。

- GPU加速

- 并行计算框架:CUDA/OpenCL实现大规模数据并行(如矩阵运算、深度学习)。

- 异步传输:重叠计算与数据拷贝时间(GPU计算时异步读取下一批数据)。

- 异构计算

- CPU处理逻辑控制,GPU处理密集计算,FPGA加速特定运算(如加密)。

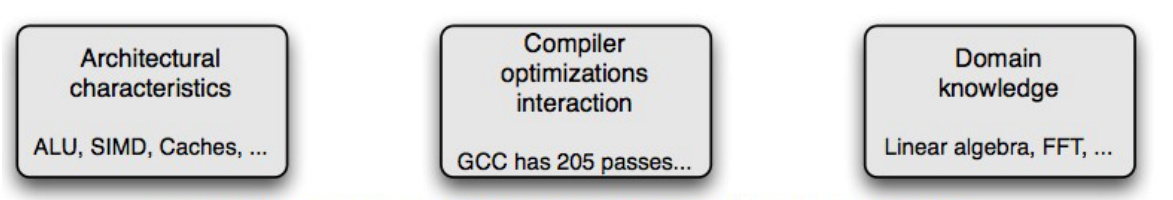

五、编译器与工具链优化

编译器自动化优化是低成本提升性能的有效手段。

-

编译器优化选项(以GCC为例):

选项 作用 适用场景 -O0无优化,便于调试 开发调试阶段 -O2平衡速度与代码大小(推荐) 生产环境部署 -O3激进优化(可能增加代码体积) 计算密集型程序 -Os优化代码体积 嵌入式设备等受限环境 -

向量化优化:编译器自动生成SIMD指令(如AVX),单指令处理多数据。

六、性能分析工具定位瓶颈

优化前需精准定位瓶颈,避免盲目优化。

- CPU分析工具:

gprof:统计函数调用时间及调用关系。perf(Linux):实时监测CPU周期、缓存命中率等。VTune(Intel):高级性能分析,支持热点函数与并发瓶颈分析。

- 内存分析工具:

Valgrind:检测内存泄漏与非法访问。memory_profiler(Python):分析内存占用峰值。

- I/O与并发分析:

perf可追踪系统调用与调度延迟。cProfile(Python):统计函数耗时与调用频次。

七、综合优化策略示例

以矩阵乘法为例:

- 算法优化:使用Strassen算法(O(n².⁸¹))替代朴素算法(O(n³))。

- 数据布局:按行存储并分块计算(Blocking)提升缓存局部性。

- 并行化:OpenMP将分块任务分配至多核。

- 指令集:编译器启用

-O3 -mavx2自动向量化。

总结

程序性能优化需遵循“测量→定位→优化→验证”循环:

- 优先算法与数据结构(复杂度决定性能上限);

- 利用编译器自动化优化(低成本收益);

- 针对硬件特性调整(缓存、并行、I/O);

- 微观代码优化辅助(循环、内存访问);

- 工具驱动精准优化(避免过度优化无效代码)。

最终目标是在资源约束下实现效率、可维护性与开发成本的平衡。